4 块存储

一:相关概念

存储的分级:

初级: 单机|单设备|磁盘管理|逻辑卷|磁盘限制

中级: 网络存储|网络文件系统|NFS|CIFS(samba)

高级: 块存储|分布式存储

锁机制解锁并行写入异常

网络文件系统:

共享目录,已经格式化的分区

块存储:

共享为格式化的分区结构,存储块

客户端可进行分区、格式化、挂载:

格式化: 单客户端: xfs、extN(使用本地的文件系统格式化)

多客户端时:集群文件系统(gfs2)

块存储核心技术:

iSCSI协议

端口: 3260

服务器端软件:target(tgt)

客户端软件: iscsi

NAS与SAN:

NAS:存储设备,接入现有的网络拓扑

SAN:存储区域网络,需要构建网络拓扑

总结:SAN中包含NAS

二:实验1 单客户端

实验环境:

server:7-1 需要增加三块硬盘

client:7-2

前提:使用网络源安装软件

实验步骤:

| 虚拟机 | 环境 | 步骤 |

|---|---|---|

| 7-1 | 服务器 | 1.配置网络源安装 epel-release扩展源,安装scsi-target-utils 2.修改tgt的子配置文件 /etc/tgt/conf.d/sample.conf 指向iqn(标签)、backing-store(共享的分区)、initiator-address(可用共享的IP或网段) 3.创建pv、vg、lv 4.启动,自启动tgtd服务、并查看绑定状态 systemctl enable tgtd --now tgtadm -L iscsi -o show -m target |

| 7-2 | 客户端 | 1.配置网络源安装扩展源,安装 iscsi-initiator-utils 2.启动自启动 iscsid 服务 3.查看: iscsiadm -m discovery -t sendtargets -p 192.168.18.201 4.连接: iscsiadm -m node -T 标签名 --login 5.利用连接的分区,创建分区(pv、vg、lv),本地类格式化,网络式永久挂载 |

扩容测试汇总

| 虚拟机 | 环境 | 步骤 |

|---|---|---|

| 7-2 | 客户端 | 1.卸载 2.断开连接 |

| 7-1 | 服务端 | 1.扩容lv 2.重启tgtd服务 |

| 7-2 | 客户端 | 1.重启虚拟机 2.检查分区是否扩容 3.pvresize 更新 4.lv更新,检查挂载点内容 |

实验详细步骤:

1)服务端配置:

1.安装软件:scsi-target-utils

[root@localhost ~]# vim ifcfg-ens33

[root@localhost ~]# grep "DNS" ifcfg-ens33

[root@localhost ~]# mv /etc/yum.repos.d/CentOS-Base.repo.bak /etc/yum.repos.d/CentOS-Base.repo

[root@localhost ~]# yum clean all;yum -y install epel-release

[root@localhost ~]# yum -y install scsi-target-utils

2.修改子配置文件: /etc/tgt/conf.d/sample.conf

[root@localhost ~]# vim /etc/tgt/conf.d/sample.conf

[root@localhost ~]# egrep -v "^#|^$|#" /etc/tgt/conf.d/sample.conf

<target iqn.2022-12.com.yq:lvm2>

backing-store /dev/data_vg/data_lv

initiator-address 192.168.18.202

</target>

3.创建pv、vg、lv

[root@localhost ~]# lsblk

[root@localhost ~]# pvcreate /dev/sdb /dev/sdc

Physical volume "/dev/sdb" successfully created.

Physical volume "/dev/sdc" successfully created.

[root@localhost ~]# vgcreate data_vg /dev/sdb /dev/sdc

Volume group "data_vg" successfully created

[root@localhost ~]# lvcreate -L 25G -n data_lv data_vg

Logical volume "data_lv" created.

[root@localhost ~]# lvscan

ACTIVE '/dev/centos/swap' [2.00 GiB] inherit

ACTIVE '/dev/centos/root' [<17.00 GiB] inherit

ACTIVE '/dev/data_vg/data_lv' [25.00 GiB] inherit

4.启动、自启动tgtd

[root@localhost ~]# systemctl enable tgtd --now

Created symlink from /etc/systemd/system/multi-user.target.wants/tgtd.service to /usr/lib/systemd/system/tgtd.service.

5.查看绑定状态

[root@localhost ~]# tgtadm -L iscsi -o show -m target

2)客户端配置:

1.安装软件:iscsi-initiator-utils

[root@localhost ~]# vim ifcfg-ens33

[root@localhost ~]# grep "DNS" ifcfg-ens33

DNS1=114.114.114.114

[root@localhost ~]# mv /etc/yum.repos.d/CentOS-Base.repo.bak /etc/yum.repos.d/CentOS-Base.repo

[root@localhost ~]# yum clean all ;yum -y install epel-release

[root@localhost ~]# yum -y install iscsi-initiator-utils

2.启动、自启动 iscsid 服务,查看iscsid服务状态

[root@localhost ~]# systemctl enable iscsid --now

Created symlink from /etc/systemd/system/multi-user.target.wants/iscsid.service to /usr/lib/systemd/system/iscsid.service.

3.查看

[root@localhost ~]# iscsiadm -m discovery -t sendtargets -p 192.168.18.201

192.168.18.201:3260,1 iqn.2022-12.com.yq:lvm2

4.连接

[root@localhost ~]# iscsiadm -m node -T iqn.2022-12.com.yq:lvm2 --login

Logging in to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.201,3260] (multiple)

Login to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.201,3260] successful.

5.利用连接的分区,创建pv、vg、lv分区,格式化,挂载,写入数据

永久挂载 /etc/fstab

/dev/www_vg/www_lv /www xfs defaults,_netdev 0 0

[root@localhost ~]# lsblk |grep sdb

sdb 8:16 0 25G 0 disk

[root@localhost ~]# vgcreate www_vg /dev/sdb

Physical volume "/dev/sdb" successfully created.

Volume group "www_vg" successfully created

[root@localhost ~]# lvcreate -L 24G -n www_lv www_vg

Logical volume "www_lv" created.

[root@localhost ~]# mkfs.xfs /dev/www_vg/www_lv

[root@localhost ~]# mkdir /www

[root@localhost ~]# mount /dev/www_vg/www_lv /www

[root@localhost ~]# df -h |grep www

/dev/mapper/www_vg-www_lv 24G 33M 24G 1% /www

[root@localhost ~]# cd /www/

[root@localhost www]# ls

[root@localhost www]# cp -a /etc/*.conf ./

[root@localhost www]# du -sh ./

132K ./

6.再次查看iscsid服务状态

[root@localhost www]# systemctl status iscsid

3)扩容:

1.客户端卸载,断开连接

#7-2

[root@localhost ~]# umount /www/

[root@localhost ~]# iscsiadm -m discovery -t sendtargets -p 192.168.18.201

192.168.18.201:3260,1 iqn.2022-12.com.yq:lvm2

[root@localhost ~]# iscsiadm -m node -T iqn.2022-12.com.yq:lvm2 --logout

Logging out of session [sid: 1, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.201,3260]

Logout of [sid: 1, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.201,3260] successful.

2.服务端扩容lv,重启tgtd服务

#7-1

[root@localhost ~]# pvscan

PV /dev/sda2 VG centos lvm2 [<19.00 GiB / 0 free]

PV /dev/sdb VG data_vg lvm2 [<20.00 GiB / 0 free]

PV /dev/sdc VG data_vg lvm2 [<20.00 GiB / 14.99 GiB free]

Total: 3 [<58.99 GiB] / in use: 3 [<58.99 GiB] / in no VG: 0 [0 ]

[root@localhost ~]# lvscan

ACTIVE '/dev/centos/swap' [2.00 GiB] inherit

ACTIVE '/dev/centos/root' [<17.00 GiB] inherit

ACTIVE '/dev/data_vg/data_lv' [25.00 GiB] inherit

[root@localhost ~]# lvresize -L +10G /dev/data_vg/data_lv

Size of logical volume data_vg/data_lv changed from 25.00 GiB (6400 extents) to 35.00 GiB (8960 extents).

Logical volume data_vg/data_lv successfully resized.

[root@localhost ~]# systemctl restart tgtd

3.客户端重启电脑,检查sdb扩容,pvresize扩容,lv更新,挂载,检查数据

#7-2

[root@localhost ~]# init 6

[root@localhost ~]# lsblk |grep -A 1 sdb

sdb 8:16 0 35G 0 disk

└─www_vg-www_lv 253:2 0 24G 0 lvm

[root@localhost ~]# pvresize /dev/sdb

Physical volume "/dev/sdb" changed

1 physical volume(s) resized or updated / 0 physical volume(s) not resized

[root@localhost ~]# lvscan

ACTIVE '/dev/www_vg/www_lv' [24.00 GiB] inherit

ACTIVE '/dev/centos/swap' [2.00 GiB] inherit

ACTIVE '/dev/centos/root' [<17.00 GiB] inherit

[root@localhost ~]# lvresize -r -L +10G /dev/www_vg/www_lv

[root@localhost ~]# lsblk |grep -A 1 sdb

sdb 8:16 0 35G 0 disk

└─www_vg-www_lv 253:2 0 34G 0 lvm

4.永久挂载:

[root@localhost ~]# vim /etc/fstab

[root@localhost ~]# tail -n 1 /etc/fstab

/dev/www_vg/www_lv /www xfs defaults,_netdev 0 0

[root@localhost ~]# reboot

[root@localhost ~]# df -h |grep www

/dev/mapper/www_vg-www_lv 34G 33M 34G 1% /www

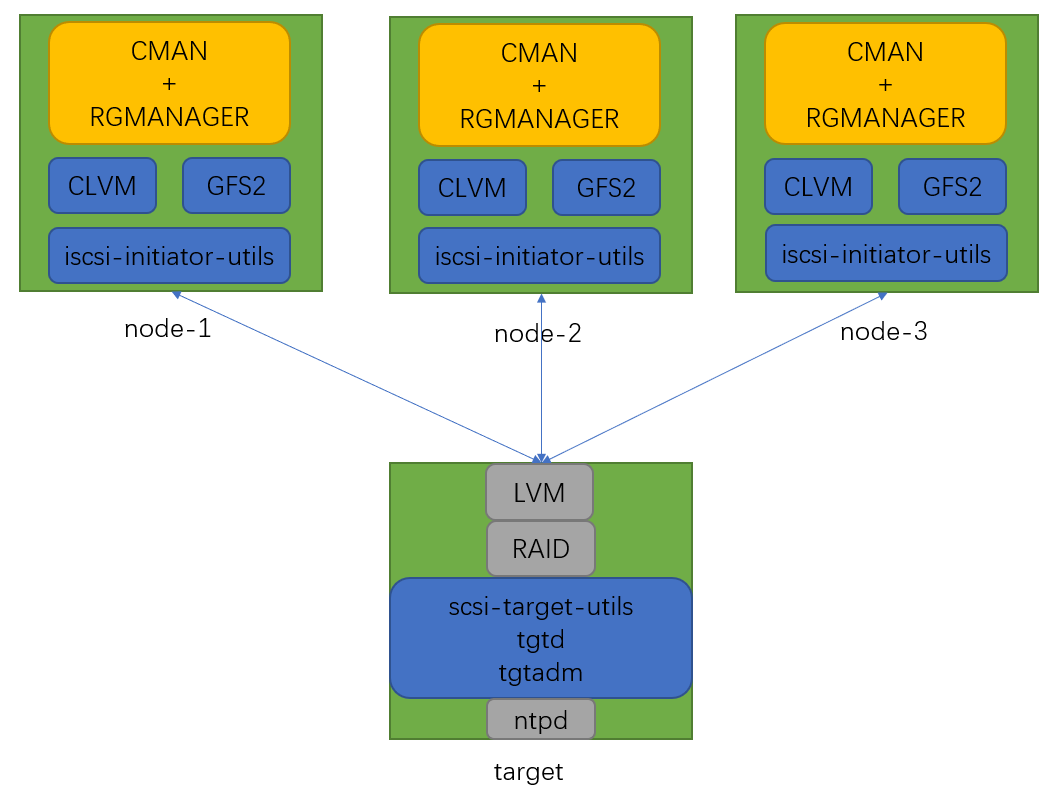

三:实验2 RHCS(基于块存储的集群)

拓展:lsscsi命令 #查看设备类型

相关介绍:

cman、rgmanager 提供集群管理功能的软件

clvm、gfs2 集群分区、集群格式化

iscsi-initiator-utils 客户端连接

实验环境:4台6版本

server 6-4 需添加三块磁盘

client 6-1、6-2、6-3

实验准备:

1:6-4需要添加三块磁盘

2:所有主机的hosts文件解析

[root@localhost ~]# vim /etc/hosts

192.168.18.40 target.yq.com target

192.168.18.10 node1.yq.com node1

192.168.18.20 node2.yq.com node2

192.168.18.30 node3.yq.com node3

3:4台服务器之间能ssh免密

ssh-keygen -t rsa -b 2048

ssh-copy-id

4:target搭建时间服务器、node1~3做客户端

#6-4时间服务器server端

[root@target ~]# vim /etc/ntp.conf

#server 0.centos.pool.ntp.org iburst #注释4行

#server 1.centos.pool.ntp.org iburst

#server 2.centos.pool.ntp.org iburst

#server 3.centos.pool.ntp.org iburst

server 127.127.1.0 #新增三行

fudge 127.127.1.0 stratum 10

restrict 192.168.18.0 mask 255.255.255.0 nomodify notrap

[root@target ~]# service ntpd start

正在启动 ntpd: [确定]

[root@target ~]# chkconfig ntpd on

[root@target ~]# chkconfig ntpd --list

ntpd 0:关闭 1:关闭 2:启用 3:启用 4:启用 5:启用 6:关闭

#node1~3 客户端配置

[root@node1 ~]# vim /etc/ntp.conf

#server 0.centos.pool.ntp.org iburst

#server 1.centos.pool.ntp.org iburst

#server 2.centos.pool.ntp.org iburst

#server 3.centos.pool.ntp.org iburst

server 192.168.18.40

restrict 192.168.18.40

[root@node1 ~]# scp /etc/ntp.conf node2:/etc/

ntp.conf 100% 1826 1.8KB/s 00:00

[root@node1 ~]# scp /etc/ntp.conf node3:/etc/

ntp.conf 100% 1826 1.8KB/s 00:00

#测试时间同步,利用别名ssh免密跳板

[root@target ~]# alias tb='for i in {1..3};do ssh node$i'

[root@target ~]# tb 'hostname';done #测试

node1.yq.com

node2.yq.com

node3.yq.com

[root@target ~]# vim ./.bashrc #写入环境配置文件永久生效

[root@target ~]# grep "alias tb" ./.bashrc

alias tb='for i in {1..3};do ssh node$i'

[root@target ~]# tb 'service ntpd start';done #客户端启动ntpd,并加入自启动

正在启动 ntpd:[确定]

正在启动 ntpd:[确定]

正在启动 ntpd:[确定]

[root@target ~]# tb 'chkconfig ntpd on';done

#node2手动修改时间

[root@node2 ~]# date -s 20001010

2000年 10月 10日 星期二 00:00:00 CST

#target查看时间,并手动同步

[root@target ~]# tb 'hostname;date;echo ====================';done

node1.yq.com

2022年 12月 05日 星期一 23:01:01 CST

====================

node2.yq.com

2000年 10月 10日 星期二 00:00:55 CST

====================

node3.yq.com

2022年 12月 05日 星期一 23:01:01 CST

====================

[root@target ~]# tb 'ntpdate -u 192.168.18.40';done

5 Dec 23:01:12 ntpdate[2008]: adjust time server 192.168.18.40 offset 0.004159 sec

5 Dec 23:01:12 ntpdate[2017]: step time server 192.168.18.40 offset 699145206.003748 sec

5 Dec 23:01:12 ntpdate[2006]: adjust time server 192.168.18.40 offset 0.003521 sec

[root@target ~]# tb 'hostname;date;echo ====================';done

node1.yq.com

2022年 12月 05日 星期一 23:01:21 CST

====================

node2.yq.com

2022年 12月 05日 星期一 23:01:21 CST

====================

node3.yq.com

2022年 12月 05日 星期一 23:01:21 CST

====================

实验步骤

| 虚拟机 | 环境 | 步骤 |

|---|---|---|

| 6-4 | target 192.168.18.40 | 1.创建分区 2.安装软件scsi-target-utils 3.修改配置文件(指向共享的分区、可连的客户端网段、连接的用户密码) 4.重启,自启动tgtd服务 5.检查绑定状态 tgtadm -L iscsi -o show -m target |

| 6-1 6-2 6-3 | node1~3进行连接 node1 192.168.18.10 node2 192.168.18.20 node3 192.168.18.30 | 1.安装软件 iscsi-initiator-utils 2.配置标签名 /etc/iscsi/initiatorname.conf (每个node不一样) InitiatorName=iqn.2022-12.com.yq:node1~3 3.配置认证信息 /etc/iscsi/iscsid.conf(每个node一样) node.session.auth.authmethod = CHAP node.session.auth.username = admin node.session.auth.password = 123456 4.利用target查看、登录 iscsiadm -m discovery -t sendtargets -p target iscsiadm -m node -T 标签名 --login |

| 6-1 6-2 6-3 | node1~3集群安装与配置 | 1.安装cman、rgmanager 2.在node1中添加集群,加入node,并将cluster.conf 发送给其他node ccs_tool create testcluster ccs_tool addfence meatware fence _manual ccs_tool lsfence ; ccs_tool lsnode 查看 ccs_tool addnode -n 1 -f meatware node1.yq.com 添加node 3.关闭NetworkManager服务 向 /etc/sysconfig/cman 中加入超时选项: CMAN_QUORUM_TIMEOUT=0 启动、自启动cman 4. 安装lvm2-cluster 启动clvm集群模式 lvmconf --enable-cluster 启动,自启动clvmd 5.找一个node测试分区,其他的同步 6.安装gfs2-utils(集群格式化软件) 找一个格式化即同步: mkfs.gfs2 -j 3 -p lock_dlm -t testcluster:sharestorage /dev/www_vg/www_lv 7.创建目录测试挂载 临时挂载: mount -t gfs2 /dev/www_vg/www_lv /www 永久挂载:echo "/dev/www_vg/www_lv /www gfs2 defaults 0 0" >> /etc/fstab 8.测试文件写入,其他的同步 |

实验步骤详细:

1、target服务器搭建

1)创建lv分区

[root@target ~]# vgcreate data_vg /dev/sdb /dev/sdc

Physical volume "/dev/sdb" successfully created

Physical volume "/dev/sdc" successfully created

Volume group "data_vg" successfully created

[root@target ~]# lvcreate -L 30G -n data_lv data_vg

Logical volume "data_lv" created.

[root@target ~]# lvscan

ACTIVE '/dev/data_vg/data_lv' [30.00 GiB] inherit

2)安装软件:scsi-target-utils

[root@target ~]# yum -y install scsi-target-utils

3)修改配置文件(指向共享的分区、可连的客户端网段、连接的用户密码)

[root@target ~]# vim /etc/tgt/targets.conf

[root@target ~]# egrep -v "^#|^$|#" /etc/tgt/targets.conf

default-driver iscsi

<target iqn.2022-12.com.yq:lvm2> #添加此处的标签内容

backing-store /dev/data_vg/data_lv

initia-address 192.168.18.0/24

incominguser admin 123456

</target>

4)重启、自启动服务 tgtd

[root@target ~]# service tgtd start

正在启动 SCSI target daemon: [确定]

[root@target ~]# chkconfig tgtd on

5)检查绑定状态

[root@target ~]# tgtadm -L iscsi -o show -m target

2、node1~3连接

1)安装软件:iscsi-initiator-utils

[root@target ~]# tb 'yum -y install iscsi-initiator-utils';done

[root@target ~]# tb 'service iscsid restart';done

停止 iscsid:

[确定]动 iscsid:[确定]

停止 iscsid:

[确定]动 iscsid:[确定]

停止 iscsid:

[确定]动 iscsid:[确定]

[root@target ~]# tb 'chkconfig iscsid on';done

2)配置标签名

[root@node1 ~]# vim /etc/iscsi/initiatorname.iscsi

[root@node1 ~]# cat /etc/iscsi/initiatorname.iscsi

InitiatorName=iqn.2022-12.com.yq:node1

[root@node2 ~]# vim /etc/iscsi/initiatorname.iscsi

[root@node2 ~]# cat /etc/iscsi/initiatorname.iscsi

InitiatorName=iqn.2022-12.com.yq:node2

[root@node3 ~]# vim /etc/iscsi/initiatorname.iscsi

[root@node3 ~]# cat /etc/iscsi/initiatorname.iscsi

InitiatorName=iqn.2022-12.com.yq:node3

3)配置认证信息

[root@node1 ~]# vim /etc/iscsi/iscsid.conf

[root@node1 ~]# grep "^node.session.auth" /etc/iscsi/iscsid.conf

node.session.auth.authmethod = CHAP

node.session.auth.username = admin

node.session.auth.password = 123456

[root@node1 ~]# scp /etc/iscsi/iscsid.conf node2:/etc/iscsi/

iscsid.conf 100% 11KB 11.5KB/s 00:00

[root@node1 ~]# scp /etc/iscsi/iscsid.conf node3:/etc/iscsi/

iscsid.conf 100% 11KB 11.5KB/s 00:00

4)利用target查看、登录,lsblk查看是否共享成功

[root@target ~]# tb 'iscsiadm -m discovery -t sendtargets -p target';done

192.168.18.40:3260,1 iqn.2022-12.com.yq:lvm2

192.168.18.40:3260,1 iqn.2022-12.com.yq:lvm2

192.168.18.40:3260,1 iqn.2022-12.com.yq:lvm2

[root@target ~]# tb 'iscsiadm -m node -T iqn.2022-12.com.yq:lvm2 --login';done

Logging in to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.40,3260] (multiple)

Login to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.40,3260] successful.

Logging in to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.40,3260] (multiple)

Login to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.40,3260] successful.

Logging in to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.40,3260] (multiple)

Login to [iface: default, target: iqn.2022-12.com.yq:lvm2, portal: 192.168.18.40,3260] successful.

[root@target ~]# tb 'lsblk |grep sdb';done

sdb 8:16 0 30G 0 disk

sdb 8:16 0 30G 0 disk

sdb 8:16 0 30G 0 disk

3、node1~3的 cman 与 rgmanager 集群安装与配置

1)安装软件:cman、rgmanager

[root@target ~]# tb 'yum -y install cman rgmanager';done

2)在node1中创建集群,添加node

[root@node1 ~]# ccs_tool create testcluster

[root@node1 ~]# ccs_tool addfence meatware fence_manual

[root@node1 ~]# ccs_tool lsfence #查看选取策略

Name Agent

meatware fence_manual

[root@node1 ~]# ccs_tool lsnode #查看node节点

Cluster name: testcluster, config_version: 2

Nodename Votes Nodeid Fencetype

#向集群中加入node

[root@node1 ~]# ccs_tool addnode -n 1 -f meatware node1.yq.com

[root@node1 ~]# ccs_tool addnode -n 2 -f meatware node2.yq.com

[root@node1 ~]# ccs_tool addnode -n 3 -f meatware node3.yq.com

[root@node1 ~]# ccs_tool lsnode

Cluster name: testcluster, config_version: 5

Nodename Votes Nodeid Fencetype

node1.yq.com 1 1 meatware

node2.yq.com 1 2 meatware

node3.yq.com 1 3 meatware

#将集群配置文件发送给其他node

[root@node1 ~]# scp /etc/cluster/cluster.conf node2:/etc/cluster/

cluster.conf 100% 677 0.7KB/s 00:00

[root@node1 ~]# scp /etc/cluster/cluster.conf node3:/etc/cluster/

cluster.conf 100% 677 0.7KB/s 00:00

3)启动cman,并加入自启动

注意:1.NetworkManager不能工作,且开机不自启

2.启动时报错,需要设置0超时的选项

[root@target ~]# tb 'service NetworkManager stop';done

停止 NetworkManager 守护进程:[确定]

停止 NetworkManager 守护进程:[确定]

停止 NetworkManager 守护进程:[确定]

[root@target ~]# tb 'chkconfig NetworkManager off';done

[root@target ~]# tb 'echo "CMAN_QUORUM_TIMEOUT=0" >> /etc/sysconfig/cman';done

#node1~3 启动cman,并加入自启动

[root@target ~]# tb 'service cman start';done

[root@target ~]# tb 'chkconfig cman on';done

4)安装clvm(集群版lvm分区命令)

启动集群模式、启动clvm、并加入自启动

[root@target ~]# tb 'yum -y install lvm2-cluster';done

[root@target ~]# tb 'lvmconf --enable-cluster';done

[root@target ~]# tb 'service clvmd start';done

[root@target ~]# tb 'chkconfig clvmd on';done

5)测试分区:

在其中一个node中创建pv、vg、lv(判断其他的同步)

#node1创建逻辑卷

[root@node1 ~]# lsblk |grep sdb

sdb 8:16 0 30G 0 disk

[root@node1 ~]# vgcreate www_vg /dev/sdb

Physical volume "/dev/sdb" successfully created

Volume group "www_vg" successfully created

[root@node1 ~]# lvcreate -L 29G -n www_lv www_vg

Logical volume "www_lv" created.

#node2查看,同步成功

[root@node2 ~]# lvscan

inactive '/dev/www_vg/www_lv' [29.00 GiB] inherit

[root@node2 ~]# pvscan

PV /dev/sdb VG www_vg lvm2 [30.00 GiB / 1020.00 MiB free]

Total: 1 [30.00 GiB] / in use: 1 [30.00 GiB] / in no VG: 0 [0 ]

#node3查看,同步成功

[root@node3 ~]# lvscan

inactive '/dev/www_vg/www_lv' [29.00 GiB] inherit

[root@node3 ~]# pvscan

PV /dev/sdb VG www_vg lvm2 [30.00 GiB / 1020.00 MiB free]

Total: 1 [30.00 GiB] / in use: 1 [30.00 GiB] / in no VG: 0 [0 ]

6)安装 gfs2-utils (集群版格式化命令)

测试格式化:在其中一个node中格式化,(判断其他的同步)

[root@target ~]# tb 'yum -y install gfs2-utils';done

#node1格式化

[root@node1 ~]# mkfs.gfs2 -j 3 -p lock_dlm -t testcluster:sharestorage /dev/www_vg/www_lv

[root@node1 ~]# blkid |grep www_lv

/dev/mapper/www_vg-www_lv: LABEL="testcluster:sharestorage" UUID="638d4b00-d269-c7d6-9ee9-65094ffece34" TYPE="gfs2"

#node2、node3同步格式化

[root@node2 ~]# blkid |grep www_lv

/dev/mapper/www_vg-www_lv: LABEL="testcluster:sharestorage" UUID="638d4b00-d269-c7d6-9ee9-65094ffece34" TYPE="gfs2"

[root@node3 ~]# blkid |grep www_lv

/dev/mapper/www_vg-www_lv: LABEL="testcluster:sharestorage" UUID="638d4b00-d269-c7d6-9ee9-65094ffece34" TYPE="gfs2"

7)测试挂载

利用target创建挂载点、写入永久挂载,挂载,并检查

[root@target ~]# tb 'mkdir /www';done

[root@target ~]# tb 'echo "/dev/www_vg/www_lv /www gfs2 defaults 0 0" >> /etc/fstab';done #写入永久挂载

[root@target ~]# tb 'hostname;df -hP|grep www';done

node1.yq.com

node2.yq.com

node3.yq.com

[root@target ~]# tb 'mount -a';done #挂载

[root@target ~]# tb 'hostname;df -h|grep www';done

node1.yq.com

/dev/mapper/www_vg-www_lv

29G 388M 29G 2% /www

node2.yq.com

/dev/mapper/www_vg-www_lv

29G 388M 29G 2% /www

node3.yq.com

/dev/mapper/www_vg-www_lv

29G 388M 29G 2% /www

[root@target ~]# tb 'hostname;df -hP|grep www';done #检查挂载成功

node1.yq.com

/dev/mapper/www_vg-www_lv 29G 388M 29G 2% /www

node2.yq.com

/dev/mapper/www_vg-www_lv 29G 388M 29G 2% /www

node3.yq.com

/dev/mapper/www_vg-www_lv 29G 388M 29G 2% /www

8)测试分区写入同步

#node1创建

[root@node1 ~]# cd /www/

[root@node1 www]# touch yq.txt

[root@node1 www]# ll

总用量 4

-rw-r--r-- 1 root root 0 12月 5 23:57 yq.txt

#node2查看

[root@node2 ~]# cd /www/

[root@node2 www]# ll

总用量 4

-rw-r--r-- 1 root root 0 12月 5 23:57 yq.txt

[root@node3 ~]# cd /www/

[root@node3 www]# ll

总用量 4

-rw-r--r-- 1 root root 0 12月 5 23:57 yq.txt